- INDEX目次

目次【非表示】

- 1.HBMが持つ4つの優れた特徴

- 1-1.特徴1:圧倒的なデータ転送速度を実現する広帯域幅

- 1-2.特徴2:チップを積層する3D構造による省スペース化

- 1-3.特徴3:少ないエネルギーで動作する高い電力効率

- 1-4.特徴4:プロセッサとの近接配置でシステム性能を最大化

- 2.従来のDDR5メモリとHBMの性能を比較

- 2-1.データ転送速度(帯域幅)の違い

- 2-2.消費電力とエネルギー効率の違い

- 2-3.チップのサイズと実装方式の違い

- 3.HBMはどのような分野で活用されているのか

- 4.生成AIや大規模データセンターの性能向上

- 4-1.スーパーコンピュータなど科学技術計算の高速化

- 4-2.高解像度グラフィックス処理や快適なゲーミング体験

- 5.HBMが抱える今後の課題

- 6.製造コストの高さと複雑な製造プロセス

- 6-1.発熱量の管理と冷却システムの必要性

- 7.HBMの将来性と今後の市場予測

- 7-1.次世代規格「HBM3E」や「HBM4」への進化

- 7-2.次世代規格「HBM3E」や「HBM4」への進化

- 8.まとめ

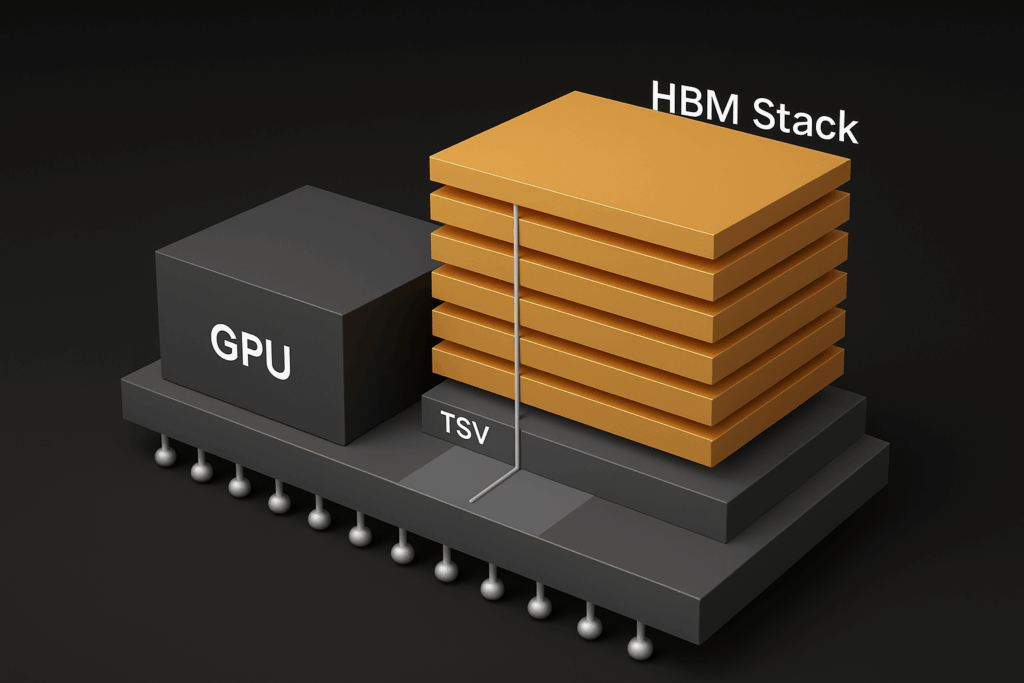

HBMとは、High Bandwidth Memoryの略称で、複数のDRAMチップを垂直に積み重ねた3D積層構造を持つ次世代の半導体メモリです。従来のDRAMとは異なり、シリコン貫通電極(TSV)を用いてチップ間を接続することで、超高速かつ大容量のデータ転送を実現しています。この革新的なmemory技術は、GPUやAIプロセッサの性能を最大限に引き出すために開発されました。AIトレーニング、スーパーコンピュータ、高性能グラフィックス処理など、膨大なデータを高速に処理する用途に不可欠な技術として注目されています。

※DRAMチップは、コンピュータやスマートフォンなどで使われるメインメモリ(RAM)の中身そのもの。

正式には Dynamic Random Access Memory(動的ランダムアクセスメモリ) の略で、

データを一時的に記憶・読み書きするための半導体チップのこと。

ひたらく言うと、DRAMチップ = 「脳の短期記憶の1セル」みたいなもの。

パソコンが「今計算してる最中の情報」や「開いてるアプリのデータ」を

一時的に保存しておくために使われる。

HBMが持つ4つの優れた特徴

HBMには主に4つの優れた特徴があります。一つ目は、広帯域幅による圧倒的なデータ転送速度で

二つ目は、DRAMチップを垂直に積み重ねる3D構造による省スペース化です。

三つ目は、少ないエネルギーで動作する高い電力効率です。

四つ目は、プロセッサとの近接配置でシステム性能を最大化できる点です。詳しくみていきましょう。

特徴1:圧倒的なデータ転送速度を実現する広帯域幅

HBM(High Bandwidth Memory)は、その名の通り、非常に高い帯域幅を持つメモリ技術で、その広帯域幅は、メモリとプロセッサ間でのデータ転送速度を飛躍的に向上させることを可能にしています。HBMは複数のDRAMチップを垂直に積み重ね、シリコン貫通ビア(TSV)と呼ばれる技術で接続する3D積層構造を採用しています。

この革新的な構造により、各チップ間のデータ転送経路が大幅に短縮され、信号の遅延を低減しながら、並列で大量のデータを高速に転送できるようになります。 例えば、HBM3では1TB/sを超えるデータ転送速度を実現しており、これは従来のDDRメモリと比較して圧倒的な高速度です。 HBMの広いインターフェース幅と短い信号経路が、この高速転送速度の実現に大きく貢献しています。

HBMの世代が新しくなるにつれて、この速度はさらに向上しており、例えばHBM3Eでは毎秒1.225TBのデータを処理できるようになっています。 このように、HBMはhighな性能を求める現代のコンピューティングにおいて、データ処理のボトルネックを解消し、システム全体のパフォーマンスを最大化する上で不可欠な技術となっています。

特徴2:チップを積層する3D構造による省スペース化

HBMは複数のDRAMチップを垂直方向に積層する3D構造を採用しているのも特徴です。この積層技術により、従来のメモリと比較して大幅な省スペース化を実現しています。HBMでは、DRAMチップの層数を増やすことで、同じ基板サイズでも大容量化と高性能化を両立できるのです。通常、HBMは4層から16層のDRAMチップを積み重ねて構成されます。HBM3Eでは最大で12層のDRAMダイが積層され、次世代のHBM4では16層に達すると予測されています。

この3D積層を実現するためには、TSV(Through Silicon Via)技術とマイクロバンプ技術が不可欠です。TSVは、シリコンウェーハを垂直に貫通する微細な配線であり、積層された各チップ間を直接接続し、高速なデータ伝送を可能にします。その直径は数マイクロメートルと極めて小さなサイズです。

また、各層のチップと、それらを統合するロジックチップやインターポーザ基板との接続には、微細なマイクロバンプという端子が用いられます。 HBMモジュールは、インターポーザ基板を介してプロセッサと接続されることで、全体として高密度なパッケージを形成し、配線距離を大幅に短縮しています。 例えば、Micron製のHBM3 Gen2は、8層積層のDRAMチップで構成されながら、従来のHBM3と同じ11mm×11mmのパッケージサイズを実現し、厚さも720µmに抑えられています。

このように、HBMはチップを積層する3D構造によって、限られたスペース内で効率的にメモリ容量と帯域幅を拡大し、高密度実装と高性能化を両立させています。

特徴3:少ないエネルギーで動作する高い電力効率

HBMはDRAMチップを垂直に積層する3D構造を採用することで、データ転送に必要な配線長を大幅に短縮し、結果的に消費電力を抑制しています。従来のDDR5メモリと比較して、HBMは同じ帯域幅で約半分の消費電力で動作するといわれています。例えば、HBM2Eの場合、1ビットあたりのエネルギー消費量は約2.1pJと非常に低く抑えられています。これは、データセンターやAI推論といった常に大量のデータを処理する環境において、電力コストの削減に大きく貢献する重要な要素です。また、HBMには信頼性を高めるためのECC(Error Correcting Code)機能が搭載されており、データの整合性を保ちながら安定した動作を可能にしています。少ないエネルギーで高い性能を発揮する電力効率の良さは、持続可能な社会の実現にも貢献するHBMの大きな強みと言えるでしょう。

特徴4:プロセッサとの近接配置でシステム性能を最大化

HBMは、プロセッサ(CPUやGPU)のすぐ近くに配置されることで、システム全体の性能を飛躍的に向上させることが可能です。従来のメモリとプロセッサは、プリント基板上で離れて配置されることが多く、この距離がデータ転送のボトルネックとなっていました。しかし、HBMではプロセッサとメモリをシリコンインターポーザ上に緊密に統合し、高密度な配線で接続しています。この近接配置により、データが長距離を移動する際の遅延が大幅に削減され、データ転送の効率が向上します。

例えば、NVIDIAのGPUでは、HBMをGPUパッケージに直接統合することで、GPUがメモリにアクセスする際のレイテンシを最小限に抑え、膨大なデータを高速で処理する能力を高めています。これにより、AIの学習や推論、HPC(高性能計算)といった大量のデータを瞬時に処理する必要があるアプリケーションにおいて、優れたパフォーマンスを発揮できるのです。この配置は、システム全体の応答速度と処理能力を最大化するための重要な要素となっています。

従来のDDR5メモリとHBMの性能を比較

HBMメモリと従来のDDR5メモリを比較すると、その性能には大きな違いがあります。DDR5メモリは、汎用性が高く多くのPCで利用されている類ですが、HBMはより専門的な用途に特化しています。特にデータ転送速度の面では、HBMが圧倒的な帯域幅を誇り、大規模なデータ処理を要求される分野でその真価を発揮します。また、省スペース性や電力効率においてもHBMは優位性があり、限られたスペースで高いパフォーマンスを求める場合に有効です。これらの性能比較から、HBMはDDR5では対応しきれない高度な計算処理に適していることがわかります。

データ転送速度(帯域幅)の違い

HBMとDDR5メモリの最大の違いは、データ転送速度(帯域幅)です。DDR5メモリの理論上の帯域幅は、DDR4の2倍にあたる40~60GB/s程度であり、将来的に80GB/sに達すると予測されています。これに対し、HBMは最初から広帯域幅をコンセプトに開発されており、HBM2は256GB/s、HBM2Eは460GB/s、HBM3は819GB/sと、驚異的な速度を実現しています。さらに、次世代のHBM3Eでは1.15TB/s(1,150GB/s)を超える帯域幅が期待されており、これはDDR5の約10倍から15倍以上の速度に相当します。たとえば、HBM3の帯域幅はDDR5の約10倍、HBM3Eでは約10倍から20倍以上という圧倒的な差があります。具体的な速度を挙げると、HBM2Eで460GB/s、HBM3では約820GB/s、HBM3Eでは1.15TB/s(1,150GB/s)に達します。この違いは、特に生成AIや高性能コンピューティング(HPC)といった、大量のデータを瞬時に処理する必要がある分野でHBMが選ばれる大きな理由となっています。

例えば、一般的なPCで使われるDDR5メモリのデータ転送速度は、最大でも約40~62GB/s程度ですが、HBM3は819GB/sに達し、HBM3Eではさらに高速な1.15TB/s(1,150GB/s)の帯域幅が実現される予定です。このように、HBMは従来のメモリと比較して圧倒的なデータ転送速度を提供し、より高度な計算や処理を可能にしています。

消費電力とエネルギー効率の違い

HBMは高い性能を発揮しつつ、優れた電力効率が特徴です。HBMとDDR5メモリを比較すると、HBMは同じデータ転送量に対してより少ない電力を消費します。これは、HBMが採用するTSV(Through-Silicon Vias)技術と3D積層構造が、信号の伝播遅延を減らし、高い動作周波数を実現しながらも消費電力を抑えているためです。

具体的には、HBMは広いインターフェース幅と短い信号経路によって、非常に高速なデータアクセスを可能にしつつ、消費電力を低減しています。一方、DDR5はDDR4の動作電圧1.2Vから1.1Vへ低減しており、消費電力の削減が図られています。しかし、HBMは単位帯域幅あたりの消費電力が低いため、データセンターや高性能コンピューティング環境での電力効率向上に大きく貢献します。

データセンターでは、電力消費量の削減が重要な課題であり、HBMの低消費電力特性は、同じ処理能力を維持しながら電力コストを大幅に削減できるため、エネルギー効率の向上に寄与します。これにより、冷却システムの負荷も軽減され、冷却コストの削減にもつながります。このように、HBMは単に性能が高いだけでなく、持続可能なITインフラ構築において重要な役割を果たす技術であると言えます。

チップのサイズと実装方式の違い

HBMとDDR5では、チップの物理的なサイズと実装方式に大きな違いがあります。HBMは3D積層技術により、複数のDRAMチップを垂直方向に重ねることで、非常にコンパクトな設計を実現しています。これにより、同じメモリ容量でもDDR5と比較して大幅に小型化できるため、限られたスペースでも高性能なメモリシステムを構築できます。例えば、HBM2のチップサイズは約5.5mm×7.1mmで、厚さは4スタック時で約0.4mmです。

DDR5メモリは、従来のDDRメモリと同様にプリント基板上に平面的に配置されるのに対し、HBMはインターポーザーと呼ばれる中間基板を介してプロセッサチップと直接接続されます。 この直接接続方式とTSV(Through Silicon Via)技術による垂直配線により、HBMは広帯域幅と省スペース化を両立しています。

一方、DDR5はマザーボードのメモリスロットにモジュール(DIMM)を介して接続される一般的な実装方式です。 DDR5対応のマザーボードは、幅広いラインナップで提供されており、モバイル用途を含む多様なPCシステムに採用されています。

HBMの積層技術は、データセンターやAIプロセッサなどの高性能コンピューティング分野でその優位性を発揮しますが、製造コストの高さや複雑な製造プロセス、発熱量の管理といった課題も抱えています。 これに対して、DDR5はコスト効率が高く、幅広い用途で普及しています。 将来的には、モバイルデバイス向けに小型化と低消費電力を追求した「モバイルHBM」の開発も進められており、スマートフォンなどへの採用が期待されています。

HBMはどのような分野で活用されているのか

HBMは、高帯域幅と電力効率の高さから、特にAIや高性能コンピューティング(HPC)の領域で重要な役割を担っています。大規模なAIモデルの学習や推論、ビッグデータ解析では膨大なデータ処理が求められるため、HBMの高速データ転送能力がシステム全体の性能を大きく左右します。

また、スーパーコンピュータのような科学技術計算や、気象予測、医薬品開発といった分野においても、HBMは複雑なシミュレーションや解析を高速化し、エネルギー効率の最適化に貢献しています。

さらに、高解像度グラフィックス処理を必要とするGPUや、高精細なゲーム体験においても、HBMはデータ処理のボトルネックを解消し、性能向上に不可欠な存在となっています。

生成AIや大規模データセンターの性能向上

HBMは、生成AIの急速な発展とそれに伴う大規模データセンターでの需要拡大を支える、極めて重要な技術です。特に、ChatGPTのような大規模言語モデルの学習や推論には、膨大なデータと高速な計算処理が必要とされます。HBMは、このような要求に応えるために開発された次世代メモリであり、AI専用プロセッサの性能を最大限に引き出すことが可能です。

NVIDIAのGPUは、HBMを搭載することでその性能を大きく向上させています。例えば、NVIDIAの「A100」や「H100」といったGPUは、AIやHPC(高性能コンピューティング)の処理能力を大幅に引き上げるためにHBMを実装しています。 HBMは、従来のDDRメモリに比べて圧倒的なデータ転送速度と電力効率を実現し、GPUとHBMを組み合わせることで、複雑なニューラルネットワークのトレーニングやリアルタイム推論を効率的に実行できます。

また、データセンターでは、膨大なデータの処理と同時に消費電力の抑制も求められており、HBMはその両方に対応できるため、AIとデータ処理の基盤として広く採用されています。 今後、AIアプリケーションの多様化や自動運転技術、量子コンピューティングなど、高度なデータ処理能力が求められる分野でのHBMの活用がさらに進むと予想されています。

半導体メーカー各社もHBMの開発に注力しており、特にSKハイニックスやサムスン電子、MicronなどがHBM市場を牽引しています。 IntelもHBM技術の進化に貢献しており、業界全体でHBMのさらなる高性能化と大容量化が進められています。

スーパーコンピュータなど科学技術計算の高速化

スーパーコンピュータは、気象予測シミュレーション、新薬開発、宇宙物理学の研究など、複雑な科学技術計算を高速で行うために不可欠な存在です。これらの計算では膨大なデータを同時に処理する必要があり、HBMの広帯域幅はデータ転送のボトルネックを解消し、計算速度を飛躍的に向上させます。例えば、HBMはグラフィックス処理だけでなく、科学技術計算分野でも性能を発揮し、スーパーコンピュータの処理能力を向上させるために役立っています。さらに、HBMは、特定の用途に合わせて設計されるカスタムチップにおいて、その性能を最大限に引き出すための重要な要素となります。これにより、個々の研究機関や企業が独自のニーズに合わせて、HBMを搭載した高性能なシステムを構築し、特定のクラスの計算処理を効率的に実行できるようになります。この技術革新は、研究開発のスピードアップに大きく貢献するでしょう。

高解像度グラフィックス処理や快適なゲーミング体験

HBMは、その広帯域幅と低消費電力特性により、高解像度のグラフィックス処理や快適なゲーミング体験を求める分野で非常に重要な役割を担っています。たとえば、最新のゲーム機やゲーミングPCでは、4Kや8Kといった超高解像度でのプレイや、VR/ARといった没入感の高いコンテンツにおいて、膨大なグラフィックスデータをリアルタイムで処理する必要があります。HBMはこれらのデータ転送を高速化し、描画の遅延を抑えることで、より滑らかで美しい映像表現を実現し、プレイヤーにストレスのない快適なゲーミング体験を提供します。また、自動運転技術が進化する車載システムにおいても、周囲の状況を正確に認識し、リアルタイムで判断を下すために、高性能なグラフィックス処理能力が不可欠です。HBMの活用により、より高度な画像認識や経路探索が可能になり、安全で快適な自動運転の実現に貢献しています。さらに、高解像度の動画編集やCG制作といったプロフェッショナルな分野でも、HBMの高速処理能力は作業効率を飛躍的に向上させ、クリエイターの創造性を最大限に引き出す手助けをしています。これらの用途におけるHBMの採用は、今後の通信技術の発展と相まって、さらに広がるものと予想されます。

HBMが抱える今後の課題

HBMはその高い性能の一方で、製造コストや発熱といった課題を抱えています。HBMの製造にはTSV(Through-Silicon Via)技術や微細な積層プロセスが必要なため、製造が複雑でコストが高くなる傾向にあります。また、3D積層構造により多数のメモリチップが狭い範囲に集約されるため、動作時に発生する熱量が多く、高性能な冷却システムが不可欠です。これらの課題を克服するため、製造プロセスの成熟や冷却技術の革新が進められています。例えば、液浸冷却やチップ内部に冷却水路を設ける埋め込み型冷却などの技術開発が期待されています。これらの課題を解決し、コスト削減と熱管理を最適化することが、HBMのさらなる普及と発展の鍵となるでしょう。

製造コストの高さと複雑な製造プロセス

HBMの大きな課題の一つは、その製造コストの高さにあります。HBMは、複数のDRAMチップを垂直に積層し、TSV(シリコン貫通ビア)と呼ばれる微細な穴で接続するという、複雑な製造プロセスを経ています。この積層技術は、従来のDRAM製造に比べて、より高度な技術と設備を必要とし、結果として製造コストの増加につながるのです。また、各チップ間の正確な位置合わせや、TSV接続の信頼性を確保するための研究開発にも多大な費用がかかっています。これらの要因により、HBMを搭載した製品は、現状では高い価格設定にならざるを得ません。特に、大規模なデータセンターやAIシステムなど、大量のHBMを必要とする分野では、このコストが導入をためらう要因となることもあります。今後は、製造プロセスの効率化や、材料コストの低減、そして新たな製造法の確立などが求められています。

発熱量の管理と冷却システムの必要性

HBMは複数のDRAMチップを垂直に積み重ねる3D積層構造を採用しており、従来のDDRメモリと比較して圧倒的なデータ転送速度と高い電力効率を実現しています。しかし、この高密度な積層構造と高速動作は、大きな熱を発するという課題も抱えています。特に、HBM4世代ではGPUの処理負荷の一部をベースダイが担うことで、ベースダイの発熱量が大幅に上昇しており、この熱の管理が非常に重要です。 適切な熱管理が行われない場合、電子部品の性能低下や故障、システムの信頼性低下、さらには寿命の短縮につながる可能性があります。

そのため、HBMの性能を最大限に引き出し、安定稼働を維持するには、効率的な冷却システムが不可欠です。現在、HBMの熱課題を克服するため、新しい冷却技術や熱設計の最適化が盛んに研究されています。例えば、HBM4で採用されている上部ヒートシンクへの液冷注入方式だけでなく、次世代のHBM5ではベースダイとパッケージ全体を冷却液に浸す「浸漬式冷却」構造の採用が検討されています。 さらに、HBM7ではDRAMチップ間に冷却液を流し込む「埋込型冷却技術」や、液体用TSV(流体TSV)の設計も進められており、今後のHBMの進化において冷却能力が重要な競争軸となることが予想されます。

HBMの将来性と今後の市場予測

次世代メモリ技術である High Bandwidth Memory(HBM)は、生成AIや高性能コンピューティング(HPC)、データセンターの拡大を背景に急速に需要が増加しています。実際、複数の市場調査レポートによれば、2024年時点でHBM市場はおおよそ 米 23〜25 億ドル 程度の規模に達しており2030年までには 米 9〜10 億ドル(又はそれ以上) に成長するという予測も出ています。

さらに、業界では「HBM4世代において、顧客仕様のロジックダイ(カスタムベースダイ)を組み込んだ高付加価値モジュールが主流化する見込み」であると報じられています。

このように、HBM市場は「AI/HPC/データセンターという高速・大容量処理用途」の拡大を受けて、構造的な成長フェーズに入っていると判断できます。

Source:High Bandwidth Memory Market Size & Share Analysis – Growth Trends & Forecasts (2025 – 2030)

Source:High Bandwidth Memory (HBM) Market Forecasts to 2030

Source:SK Hynix expects AI memory market to grow 30% a year to 2030

次世代規格「HBM3E」や「HBM4」への進化

HBMは、高帯域幅と低消費電力を両立させるため、進化を続けています。現在の最新規格であるHBM3は、2022年1月にJEDECによって発表されました。HBM3の次世代となるHBM3Eは、HBM3と比較してさらにデータ転送速度が向上しており、最大12層のDRAMスタックに対応することで、最大36GBの容量を実現しています。例えば、HBM3Eは最大で9.6Gb/sのデータレートをサポートし、16層スタックでは48GBの容量を持つ製品も登場しています。

そして、HBM3Eの次、次世代規格となるのがHBM4です。HBM4は2025年4月にJEDECによって公式に発表されました。HBM4では、HBM3Eまでの1,024ピンから2,048ピンへと入出力ピン数が2倍に増加し、これにより入出力帯域幅が約1.5倍に拡大する見込みです。

これにより、HBM4はHBM3Eと比較して帯域幅が60%以上向上し、最大2TB/sを超える転送速度を実現するとされています。容量面でも進化を遂げ、DRAMダイの積層枚数を16枚に増やすことで、モジュールあたりの容量が最大48GBに達し、さらに32GbのDRAMダイを使用することで64GBもの大容量が実現可能になります。

SK HynixやMicronといった主要メーカーは、HBM4の量産を2025年から2026年にかけて開始する予定であり、AI半導体市場の拡大を支える重要な技術として期待されています。

次世代規格「HBM3E」や「HBM4」への進化

生成AIの急速な普及と大規模データセンターの需要拡大を背景に、AI半導体市場は成長を続けており、それに伴いHBMの需要も増加しています。NVIDIAをはじめとするAIチップ大手メーカーは、高性能なAIアクセラレータにHBMを不可欠な部品として採用しています。

市場調査会社であるReport Oceanによると、半導体におけるAI市場は2025年から2033年にかけて年平均成長率18.11%で成長し、2033年には3,216億6,000万ドルに達すると予測されています。 また、Fortune Business Insightsの予測では、世界の半導体市場全体は2025年から2032年にかけて年平均成長率15.4%で成長し、2032年には2兆625億9,000万ドルに達するとされています。 この成長は、HBMメーカーにとって大きなビジネスチャンスであり、SKハイニックス、Samsung(サムスン)、Micronなどの大手企業が市場の大部分のシェアを占めています。これらのメーカーは、AIチップメーカーとの協業を強化し、次世代HBMの開発と量産に注力しており、今後も需要の増加に対応するため、生産能力の増強や技術革新を進めていくと見られています。AMDのような企業も、AIプロセッサへのHBM採用を加速しており、市場全体の競争が激化しつつあります。

まとめ

HBMは、従来のDDR5メモリと比較して、データ転送速度、省スペース性、高い電力効率において優れた性能を発揮するメモリ技術です。チップを3Dに積層する独自の構造により、広帯域幅と低消費電力を両立し、特にAIやHPC(高性能コンピューティング)分野でその真価を発揮しています。現在、HBM3EやHBM4といった次世代規格の開発が進められており、これらの技術は今後も進化を続けると見込まれています。HBMは、高まるデータ処理需要に応える次世代の半導体メモリとして、今後も様々な技術革新を牽引していくでしょう。

西進商事コラム編集部

西進商事コラム編集部です。専門商社かつメーカーとしての長い歴史を持ち、精密装置やレーザー加工の最前線を発信。分析標準物質の活用も含め、さまざまなコラム発信をします。

PLCとは?シーケンサとは?わかりやすくどんな装置か基礎知識を徹底解説!

yag(ヤグ)レーザとは?仕組みや特徴・用途を説明

エキシマレーザとは?用途や特徴・仕組みについて解説

アングストローム技術とは?オングストローム時代の半導体の仕組み